为什么“逐篇精读”是写综述的死路?

在 AI 时代,传统的线性阅读方式效率极低:

- 吞吐量过低: 一篇看 2 小时,看完第 5 篇忘了第 1 篇。

- 笔记不可检索: 只有零星的高亮,没有统一的结构,写文章时找不到证据。

- 冲突被忽略: 没发现 Paper A 和 Paper B 的样本完全相反,错失了讨论“边界条件”的机会。

- 引用无“论证用途”: 引用是为了凑数,而不是为了支撑你的观点。

你需要从“阅读者”转型为“情报分析师”。

个人兜底流程:批量提取 + 交叉验证

想要写出高分综述,必须建立流水线作业。

第一步:批量建立“元数据清单”

不要打开 PDF 就读。先在 Excel 或 Notion 里建表,列出核心字段:

- 主题 (Theme)

- 方法 (Method)

- 样本特征 (Sample)

- 年份 (Year)

第二步:统一字段抽取(Structured Extraction)

不要通读全文。每篇文献只抓取 4 个“可写作”的信息块:

- 主张 (Claim): 作者的核心观点是什么?

- 证据 (Evidence): 用了什么数据支撑?(P值?访谈原话?)

- 边界条件 (Boundary): 这个结论在什么情况下成立?(例如:只在发展中国家成立)。

- 局限 (Limitation): 作者承认自己哪里没做好?

第三步:主题聚类 (Thematic Clustering)

不要按作者写,要按论点写。 将提取出的信息按“阵营”分类:

- 阵营 A: 支持“正相关”的研究(Paper 1, 3, 5)。

- 阵营 B: 支持“无相关”的研究(Paper 2, 4)。

第四步:交叉验证 (Cross-Validation)

这是拿高分的关键。寻找冲突点:

- “为什么 Paper 1 说有效,Paper 2 说无效?”

- “哦,原来 Paper 1 用的是学生样本,Paper 2 用的是企业高管。” 这就是你的批判性分析!

第五步:输出段落模板

套用公式直接写作:

- 共识(大家都同意 X 重要)→ 分歧(但 X 如何影响 Y,学者们有争议)→ 证据对比(Smith 认为是正向,而 Johnson 认为是负向)→ 原因分析(这可能是样本差异导致的)→ 缺口与定位(因此,本研究将……)。

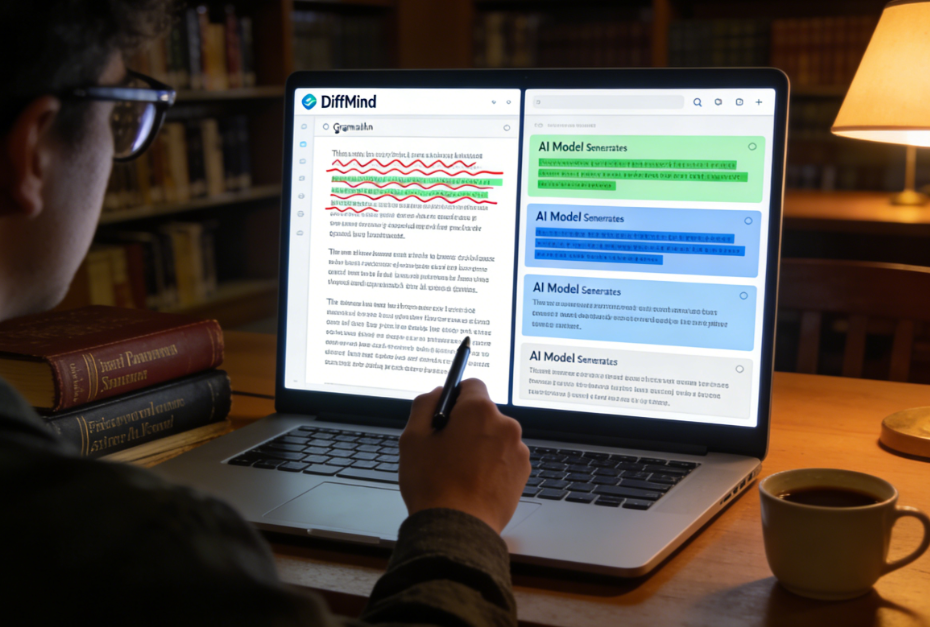

DiffMind 实战:多模型 AI 帮你完成“情报清洗”

手动做字段提取和交叉验证非常耗时。DiffMind(多模型 AI 对比工具)能完美适配这个流程。

1. 提问增强:实现“字段化抽取”

你不能只把 PDF 丢给 AI 说“总结一下”。 利用 DiffMind 的提问增强,将指令转化为标准 JSON 抓取模式:

“作为学术助理,请阅读附件论文,并严格按以下格式输出:

- Core_Claim: 一句话概括核心发现。

- Evidence_Type: 定量还是定性?

- Key_Data: 核心统计数据或引用。

- Context: 研究背景(国家/行业)。

- Gap: 作者提到的未来研究方向。” 这样生成的笔记,可以直接复制粘贴进你的 Excel 矩阵。

2. 多模型对比:减少误读,发现“隐形冲突”

单一模型可能会遗漏关键的“限制条件”。 在 DiffMind 中,同时使用 GPT-4o 和 Claude 3.5 分析同一篇论文:

- GPT-4o 擅长提取硬数据(样本量、模型参数)。

- Claude 3.5 擅长捕捉作者的语气和潜在的逻辑漏洞。 实战技巧: 如果两个模型对“结论”的总结不一致,往往意味着这篇论文的结论有复杂的限定条件,这正是你需要人工介入精读的地方。

3. AI 分工流水线:从聚类到写作

让不同的模型承担不同角色:

- 模型 A(聚类): “这里有 5 篇论文的摘要,请根据研究方法将它们分为两类。”

- 模型 B(找反例): “针对‘社交媒体导致焦虑’这一观点,请在上传的文献中找出反驳或限制这一观点的证据。”

- 模型 C(综合): “基于上述的共识和分歧,写一段 200 字的 Literature Review,要求学术语气,包含引用占位符。”

结语

文献综述的本质不是“读书笔记”,而是“逻辑拼图”。 通过“批量提取 + 交叉验证”的策略,并结合 DiffMind 的多模型能力,你不再是被淹没在 PDF 海洋里的留学生,而是驾驭信息的指挥官。这才是 academic reading efficiency 的终极奥义。